L’apparition des écrans Retina [1] sur les mobiles, les tablettes, puis maintenant sur certains ordinateurs portables d’Apple fait les délices des amateurs (fortunés) de technologies dernier cri. Ces écrans présentent une résolution correspondant au double de celle des écrans traditionnels. Les éléments visuels (textes, icônes, images) y sont affichés avec une grande finesse et un piqué remarquable, au point qu’on ne discerne pratiquement plus les pixels. Les typographies, mieux lissées, apportent aussi un meilleur confort de lecture.

Jusqu’à aujourd’hui, les écrans Retina n’étaient utilisés que sur des périphériques mobiles tels que smartphones et tablettes. Leur arrivée sur de « vrais » ordinateurs soulève quelques problèmes. Il faudra que l’industrie logicielle, et en particulier celle qui est consacrée au web, digère cette nouvelle norme. Car il ne faut pas se leurrer, il s’agit bien d’une nouvelle norme. Les normes industrielles ne sont pas toujours édictées par une assemblée de bons esprits éclairés qui se concertent longuement pour inventer les progrès censés faire le bonheur de l’humanité. Souvent, ces normes s’établissent de force par une saturation du marché. Apple a pris l’habitude de mettre en place des changements radicaux sur ses produits, dont plusieurs (mais pas tous !) finissent, après quelques cris d’orfraie, par devenir des standards suivis par tous les industriels bien obligés de s’adapter pour rester dans la course. On peut parier qu’à terme, tous les fabricants de dalles proposeront ce type d’écrans à des prix toujours plus accessibles. Et on peut parier, avec presque autant de certitude, que ces nouveaux écrans deviendront un jour majoritaires. Et l’industrie logicielle suivra.

C’est une chose que d’imposer des modifications logicielles sur des appareils aussi récents que les smartphones et les tablettes, c’est à dire dans un écosystème où il est facile pour une marque dominante d’imposer ses normes. Mais c’en est une autre, que de s’adresser à l’ensemble du parc informatique existant sur lequel on n’a que peu de prise. Pour le web, qui en 30 ans a réussi tant bien que mal, à se développer indépendamment du hardware, le coup sera dur. On peut parler d’un paradigme technique…

Précisons que nous ne parlons ici que des images pixelisées. Les images vectorielles, tout comme la typographie - vectorielle elle aussi - ne posent pas de problèmes de résolution et s’adaptent sans peine aux nouveaux écrans.

Petits rappels autour de la résolution des images.

Une image diffusée par un écran est composée de pixels. La taille des images se mesure en nombre de pixels. Sur internet, les images sont depuis les débuts affichées avec un ratio de 1. Par exemple, une image de 100 pixels de large occupera 100 pixels en largeur sur votre écran. Ça à l’air idiot, mais c’est une précision utile pour comprendre la suite. Les pixels n’ont pas de taille définie, ils contiennent juste des informations colorimétriques. C’est le nombre de pixels par pouce de l’écran - sa résolution - qui détermine la dimension de l’image sur cet écran. Ainsi, notre image de 100 pixels de large s’affichera plus petite sur un écran en haute définition que sur un écran « normal », car ses pixels y seront plus petits. La résolution est déterminée par le nombre de pixels par unité de surface (elle s’exprime en pixels par pouce (ppp) ou dpi en anglais).

Les écrans des ordinateurs portables ont, depuis longtemps, tendance à afficher une résolution de plus en plus élevée. La conséquence - que tout le monde a pu remarquer - est que les contenus sont affichés de plus en plus petits par rapport aux écrans « normaux ». Les écrans Retina affichant une résolution de près du double, on ne pouvait laisser ce principe se perpétuer. Pour afficher les éléments visuels dans une dimension acceptable, Apple décide donc d’appliquer un ratio de 2 à ces nouveaux écrans. Cela implique que pour remplacer une image qui jusqu’ici mesurait 100 pixels de large, il faut maintenant fournir une image de 200 pixels de large (et la hauteur change en proportion, hein). Le gain immédiat est une image avec une netteté et un piqué extraordinaires, encore jamais vus sur un écran. Une autre conséquence, tout aussi immédiate, est que le poids de cette image a quadruplé ! (100 x 100 = 1000 / 200 x 200 = 4000). On comprend que pour traiter des images aussi lourdes il faudra des puissances de calcul bien plus élevées que celles que nous connaissons. Pour le web, il faudra en plus, des bandes passantes très performantes pour ne pas ralentir le chargement des images.

Que se passera-t-il avec les « anciennes » images ?

Ces images seront dorénavant sous-échantillonnées par rapport à la nouvelle norme. Pour être vues sur un nouvel écran, elles seront artificiellement agrandies. Pour afficher 200 pixels là où il n’y a de l’information que pour 100 pixels, un logiciel ne peut rien faire de plus que d’« inventer » des pixels intermédiaires par moyenne des pixels environnants. Même le robot le plus malin ou l’algorithme le plus fou ne réussiront pas à remplacer l’information manquante ! Le résultat sera une image un peu floue. En fait, ces images ne seront pas subitement devenues mauvaises, mais leur confrontation avec les « nouvelles » images en haute résolution leur donnera un petit aspect vieillot. Les milliards d’images déjà publiées sur le Net seront-elles mises aux normes ? On peut prédire que non, l’écrasante majorité des « images d’avant » restera telle qu’elle, car pour leurs éditeurs cela représenterait un très gros travail, le jeu n’en vaudra pas la chandelle et aussi parce que les originaux permettant de les refaire ne seront pas toujours disponibles. Pire, ce patrimoine d’images, « dégradées », continuera d’alimenter encore longtemps tous les sites qui s’en servent pour leur illustration ou leur documentation.

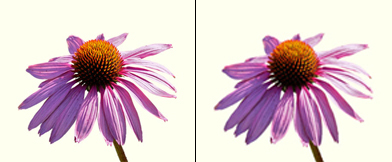

- Simulation de la différence d’affichage entre une image en haute résolution et une « ancienne ».

Pour se rendre compte de la différence en conditions réelles, on « prendra » un portable Apple avec écran Retina et on ouvrira côte à côte 2 fenêtres de navigateur, en affichant d’un côté un site optimisé avec des images en haute résolution (par exemple celui d’Apple) et de l’autre côté, un site quelconque contenant des images (quelconques). Selon son acuité visuelle, on distinguera des différences de rendu plus ou moins marquées, mais bien réelles. D’aucuns trouveront que la différence est faible, mais une fois habitués aux « nouvelles images » ils seront peut-être les premiers à trouver un petit côté vieillot aux images d’aujourd’hui. Dans un ancien billet, je notais que les réalisateurs de documentaires TV utilisaient le noir/blanc pour caractériser un document ancien et je me demandais si on trouverait une convention aussi pratique pour présenter des images d’aujourd’hui… eh bien j’ai trouvé : on montrera des images légèrement floues ;-)

Comment les technologies du web répondront-elles ?

Les smartphones et les tablettes ont été les premiers à être munis d’écrans en haute définition. On aura remarqué par ailleurs que de nombreux sites ne sont toujours pas adaptés à ces petits écrans. Pour y voir quelque chose, il faut en général zoomer, puis dézoomer et scroller en tous sens pour retrouver les boutons de navigation. C’est avec ces appareils en point de mire que le W3C a finalisé récemment de nouveaux standards permettant d’afficher des contenus adaptés au petit format : les MediaQueries. Il s’agit d’un dispositif qui met en oeuvre des techniques dites de Responsive Web Design (en français : conception de sites web adaptatifs). Quelques exemples ici. La méthode, basée sur des feuilles de style (CSS), n’agit que sur le rendu visuel, les contenus proprement dits n’étant pas affectés. On peut ainsi, pour des périphériques de petite dimension, réarranger la disposition des textes et des moyens de navigation, présenter des typographies dans des dimensions lisibles, redimensionner les images, voire supprimer certains éléments non désirés. Pour les avoir expérimentées ces derniers mois, je peux dire que ces techniques fonctionnent de manière probante. [2] Certes, la création de nombreuses feuilles de style (une par plage de dimensions et une encore pour chaque résolution de périphérique !) ne se fait pas toute seule. Lors de la conception d’un tel site, il faut prendre en compte globalement ses diverses visualisations possibles.

Cependant, à peine débarquées et encore très peu mises en oeuvre, les MediaQueries montrent déjà des limites. L’émergence des écrans Retina sur de « vrais » ordinateurs les met cruellement en lumière. L’exemple le plus frappant est le suivant : avec les MediaQueries on peut cibler des images de fond (background-image) spécifiques à chaque écran visé. Très bien, mais ces images-là sont utilisées généralement à des fins décoratives. Pour les images vraiment importantes, celles du contenu, c’est structurellement impossible avec le seul recours aux MediaQueries. On peut certes en modifier la taille d’affichage, mais c’est quand même l’image originale en entier qui est envoyée.

Il commence à se faire jour que la cohabitation entre un web « traditionnel » et un web en haute définition sera de longue durée. On ne pourra pas imposer des images 4 fois plus lourdes à qui ne peut pas en tirer profit, surtout si c’est au prix d’une connexion performante et donc chère. L’idéal sera de munir les nouveaux sites d’images en haute résolution et de mettre au point des techniques de détection capables de discerner le type d’images à fournir pour un périphérique donné ayant une vitesse de connexion donnée. Les MediaQueries étant, par essence, incapables de faire cela, certains ont déjà mis au point des « hacks » allant dans ce sens et le W3C a créé une commission pour réfléchir à de nouvelles solutions. D’autres prévoient une nouvelle « guerre du web » [3] encore plus pénible que les précédentes. Quoi qu’il en soit, la réalisation de sites web lisibles par tous va devenir complexe et cela augmentera assurément les coûts de développement. À un moment donné, quand les écrans Retina seront bien présents, les développeurs ne voudront plus perdre leur temps à développer des variantes compatibles. On se retrouvera alors avec un web à 2 vitesses : l’un pour les happy few équipés du dernier cri de l’appareillage électronique et l’autre pour les « résistants » au progrès qui ne pourront plus visualiser correctement les nouveaux sites. Sans compter tous les vieux sites évoqués plus haut, qui continueront d’afficher leurs images pas très nettes.

Il ne s’agit pas ici de déplorer tout progrès technique, mais de relever qu’en la matière, la concertation nécessaire entre instances normatives et entreprises est impossible quand les progrès techniques sont avant tout des avantages commerciaux. Le Net ressemble aujourd’hui à une autoroute qui, à peine mise en service, devrait aussitôt subir de gros travaux d’entretien qui gênent le trafic. Et on me dit dans l’oreillette que, contrairement à ce que peut laisser croire la pub d’Apple, on n’a pas encore atteint le pouvoir de résolution de l’oeil humain, on devrait pouvoir faire mieux ! Les RetinaSuperMegaPlus sont probablement déjà dans les tuyaux…

Apple n’est pas qu’un formidable moteur d’innovations technologiques entrainant toute la branche de l’électronique communicante derrière elle. C’est aussi devenu un système fermé, un système propriétaire, à l’instar des Google, Facebook ou Windows (avec son nouveau WindowStore sur le modèle de l’AppleStore), cherchant à enfermer ses clients dans sa bulle en lui offrant un maximum de services (aussi payants pour les prestataires que pour les clients). À partir de leurs smartphones, leurs tablettes et bientôt depuis leurs ordinateurs (selon les évolutions prévisibles de Mac OS), l’internet est la seule porte permettant de s’échapper de la cage. Les apps fournissent presque tous les services qu’un cyberhominidé peut vouloir désirer. Ces apps sont complètement sous le contrôle d’Apple, qui décide de tout, depuis les contenus jusqu’à la manière de les afficher, en passant bien sûr par l’imposition de ses conditions économiques. Dès lors, il est pour le moins troublant de constater que les seuls éléments qui ne s’affichent pas aussi joliment que ceux d’Apple, en proposant des images un peu pourries, sont ceux qui viennent d’ailleurs, de ce monde imparfait que les ingénieurs de Cupertino n’ont pas (encore) régenté. Si cet effet n’est probablement pas recherché, gageons qu’il ne devrait pas trop déplaire à Apple !

Retina Display – The Future of Web Design. Internet Overview. On trouvera sur cette page une grande quantité de liens (anglophones) qui donnent un bon « état de l’art » sur les écrans Retina. Elle s’adresse plutôt aux webdesigners.

Notes:

[1] Le terme Retina est une marque commerciale utilisée par Apple, Android utilise les termes HDPI ( 240dpi) et XHDPI ( 320dpi).

[2] Compatibilité des MediaQueries : Androïd ne les gère que depuis la version 3 (janvier 2011). Pour Internet Explorer, il faut la version 9 pour avoir un début de compatibilité et la 10 pour une prise en charge complète. Chez Apple toutes les versions de iOs et les versions récentes de Safari sont compatibles. Firefox est compatible depuis la version 3.5 (décembre 2009).

[3] Dans ces guerres du web, on pense surtout à celles des navigateurs (Explorer et Netscape) qui, dans un esprit de compétition et d’innovation, ont vu se développer des versions munies de fonctions propriétaires qui se démarquaient non seulement du concurrent, mais surtout des standards du web. Certains sites ne fonctionnaient qu’avec un seul navigateur et n’étaient souvent pas rendus compatibles avec d’autres. Cette bagarre a causé de très gros soucis aux développeurs qui tenaient à être lus de tout le monde et coûté des millions en frais de développement supplémentaires. Pour en savoir plus, on lira cette page.

Document brut, hier soir dans Metropolis, sur Arte. [1] Rebecca Manzoni nous annonce, en substance : « C’est un métier qui va bientôt passer dans la catégorie « disparu ». Avec le numérique, l’argentique, c’est bientôt terminé. Et Françoise Huguier le déplore. » On assiste alors à une séance de travail plutôt banale entre Françoise Huguier et son tireur Gérard Binisti, dont on ne retire pas grand-chose. Un peu plus rouge ici un peu moins foncé là, bref la popote ordinaire. On aurait voulu savoir, peut-être, pourquoi l’argentique serait plus approprié pour ces photos là...? Ou bien pourquoi la dame elle ne fait pas des images comme tout le monde, en numérique et en les ajustant avec précision sur Photoshop...? On ne le saura pas, mais le fantasme du « c’était-quand-même-mieux-avant » a été instillé au passage.

Pourtant, le dernier plan du reportage est révélateur (si j’ose dire) : on y voit la photographe argentique photographiant les trois tirages d’essai avec son iPhone. Quand on vous dit que le numérique est en marche !

Pourtant, le dernier plan du reportage est révélateur (si j’ose dire) : on y voit la photographe argentique photographiant les trois tirages d’essai avec son iPhone. Quand on vous dit que le numérique est en marche !

Notes:

[1] Ça repasse en ce moment et c’est visible en ligne ici, dès la 34e minute (mais j’ignore pour combien de temps...)

Le Musée suisse de l’appareil photographique de Vevey présente sa nouvelle exposition : La révolution numérique.

Cela fait 40 ans que l’électronique s’est peu à peu invitée sur les appareils photographiques. Mais, le remplacement du film argentique par un dispositif numérique au moins aussi performant est bien plus récent : c’est vers 2003-2004 qu’un renversement des technologies s’opère. Par renversement, nous entendons qu’une majorité des acteurs se convertissent à ces nouvelles technologies. Depuis, nous assistons au développement fulgurant du numérique, de ses usages et de sa dissémination.

La photo numérique a-t-elle, pour autant, déjà une histoire ? Selon André Gunthert, qui présentait une conférence sur cette question, en avril 2008, dans ce même musée, il n’existe pas de véritable histoire de la photographie numérique. Deux ans et des milliards de pixels plus tard, ce constat est-il toujours valable ? Sur le plan théorique, il est probable que les bouleversements gigantesques auxquels nous assistons en direct ne nous permettent pas encore de prendre suffisamment de hauteur... L’élaboration de théories nouvelles - et surtout leur large acceptation - est rendue plus difficile par la prégnance de concepts élaborés à l’époque argentique. [1]

Néanmoins, l’exposition qui vient de s’ouvrir à Vevey nous prouve que l’histoire de la photo numérique, sur le plan du matériel et de la technique, est déjà foisonnante, malgré ses débuts récents. Les appareils rassemblés ici nous font voir toute une histoire des techniques, dont on avait (déjà !) un peu oublié les détours, les culs de sac et les réussites. Si certains appareils nous font sourire, tant ils paraissent lourdauds et peu performants, d’autres nous étonnent par leur côté visionnaire. Bien sûr, cet aspect visionnaire ne se voit qu’après, quand les choix technologiques et commerciaux successifs montrent le cheminement d’une idée vers son succès. Comme toujours, la prospective est un métier difficile.

Quelques repères et dates...

1965. Première photographie numérisée connue.

Cette image a été réalisée au moyen de petites bandelettes de papier colorées et collées à la main sur un grand panneau. Chaque papier affichait une couleur digitalisée, transmise par radio depuis une sonde en orbite autour de Mars. Détails ici.

- © Nasa Images

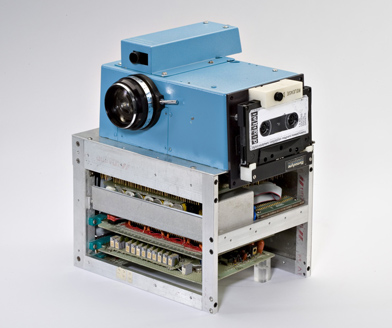

1975. Steven J. Sasson, chercheur chez Kodak

réalise le premier appareil de prise de vue numérique en combinant 3 technologies existantes : un convertisseur analogique-numérique Motorola, un appareil photographique Kodak et un capteur CCD Fairchild. 3,6 kg pour produire une image de 100 x 100 pixels.

1981. Sony met au point la première caméra Mavica

dont le film est remplacé par une vidéo analogique arrêtée (still video). Les données sont enregistrées sur une disquette magnétique. La même année, Sony lance la disquette 3.5 pouces, qui fit la carrière que l’on sait (et dont on vient d’annoncer la fin de la production pour mars 2011).

Il est intéressant de noter à ce stade que les principes essentiels des technologies actuelles de postproduction de photos ont été mis au point bien avant que les capteurs numériques n’arrivent sur le marché. Toute l’industrie graphique avait déjà « fait sa révolution », avec l’apparition de la photocomposition (dès les années 70), puis des scanners permettant de reproduire digitalement les photos argentiques. Le développement d’ordinateurs de plus en plus performants, munis de logiciels de mise en page et de traitement d’images a scellé « la marche en avant du progrès ». Dès 1990 le logiciel Photoshop voit le jour et permet aux aficionados de découvrir les joies de la manipulation des images [2]. Quand la photographie numérique a été suffisamment performante, elle a pris sa place tout naturellement (comme un chaînon manquant !) dans cette chaine de production graphique déjà parfaitement rodée. Cette rapide intégration a surpris plus d’un photographe professionnel.

La transmission rapide des images est un autre élément déterminant du succès de la photo numérique. Jusqu’alors, le bélinographe avait été très utilisé par les agences de presse, et cela, dès les années 40. En 1984, à l’occasion des Jeux olympiques de Los Angeles, Hasselblad met au point un dispositif très performant (pour l’époque) de transmission des images. Mais, dès 1990, la naissance du World Wide Web change radicalement la donne. La transmission de photos n’est alors plus réservée aux agences de presse et se met à la portée de pratiquement tout le monde, ce qui aura aussi pour conséquence de donner le jour à un développement important de pratiques amateurs jusqu’alors inédites.

C’est donc à partir de 1990 que tout se précipite.

Outre la naissance de Photoshop, on y voit apparaitre le premier appareil entièrement numérique, le Fotoman de Logitech qui affiche 320 x 240 pixels directement sur l’écran de l’ordinateur. Cette faible résolution ne permet pas vraiment une utilisation professionnelle, mais il ouvre une perspective, il montre ce qui pourrait être un chemin vers quelque chose qu’on percevait dans le très lointain. [3]

En 1991 Kodak lance le système DCS.

Il s’agit d’un Nikon f3 muni d’un dos numérique à capteur CCD relié à une unité de stockage avec batteries et écran de visualisation. Ça commence à prendre forme, mais c’est encore lourd ;-)

- © Musée suisse de l’appareil photographique Vevey

Toujours autour des années 1990, on assiste à la naissance de divers procédés de prises de vue basés sur l’utilisation d’un scanner en guise de dos pour des chambres techniques en grand format (Sinar). Le procédé ne permet évidemment pas l’instantané, il est lourd, lent et cher. Beaucoup de photographes de studio continuent de photographier sur du film grand format qui est ensuite scanné pour répondre à la demande des clients qui prennent goût aux avantages du traitement numérique.

1992. Le Photo CD.

Le CD-ROM, apparu en 1985, servira de base à Kodak pour le développement du Photo CD. Pendant quelques années, ce service qui scanne les photos argentiques pour les stocker, les lire et les traiter sur un ordinateur sera une passerelle très fréquentée pour accéder à des photos de provenance argentiques en haute résolution sur un ordinateur.

Dès 1995 apparaissent les premiers appareils numériques

s’adressant au grand public. Peu performants à nos yeux d’aujourd’hui, ils restent chers et s’adressent donc à des passionnés de technique. Mais le petit miracle de l’image qui apparait instantanément sur le petit écran incorporé fait son effet, tout comme sa disponibilité immédiate sur son ordinateur. En quelques années l’industrie met au point des appareils de plus en plus puissants et - grâce à une diffusion élargie - parvient à abaisser le prix des appareils.

- Un Mavica de 1998

- © Musée suisse de l’appareil photographique Vevey

De cette époque datent différentes approches des systèmes de visée. Ceux-ci ont une importance, non seulement sur le confort et les performances, mais aussi sur les prix et, finalement, sur les catégories de public auxquelles ils s’adressent. Le viseur optique traditionnel fait souvent partie de l’équipement de base, mais il est moyennement apprécié et on lui préfère généralement la visée directe au moyen de l’écran. C’est ce double système qui équipe encore la plupart des appareils d’entrée de gamme. Mais le besoin d’une visée reflex se fait sentir. Pour pallier à la difficulté de sa réalisation (et aux prix qui en découle), on voit apparaitre des appareils « bridge » qui procurent une vision de type reflex (c. à d. à travers l’objectif) mais en vidéo, à la place d’une vision optique directe. Ce système ingénieux a été, à mon avis, injustement décrié par des puristes et on n’en trouve plus guère aujourd’hui. Les vrais appareils reflex , chers, finiront par séduire les amateurs-experts tout comme les pros. Mais ce n’est que récemment que l’industrie est parvenue à proposer des appareils reflex permettant aussi de viser au moyen de l’écran.

En 1999 apparait le reflex numérique Nikon D1.

Avec son capteur de 2,74 mégapixels (battu en brèche aujourd’hui par le moindre des camphones ;-) on le considère comme le premier reflex de niveau professionnel. C’est vers cette époque que débute une course vertigineuse aux performances. La concurrence acharnée que se livrent les différentes marques en laissera quelques unes sur le carreau.

C’est entre 2003 et 2004 que les préférences technologiques

des amateurs comme des professionnels basculent vers le numérique. Il est intéressant de constater ici que c’est le développement des appareils amateur qui a mené à la réalisation des appareils reflex performants s’adressant aux professionnels. (Dans beaucoup d’autres domaines industriels, on prône un modèle inverse, qui va des matériels de pointe pour les pros vers des applications grand public.) Les photojournalistes, pressés par leurs rédactions, sont les premiers à s’en servir. Mais ils n’y croient pas trop et doublent encore souvent leurs prises de vues en argentique. Du côté des appareils de studio, les dos numériques bénéficient des mêmes progrès technologiques et deviennent extrêmement performants, atteignant parfois les 50 millions de pixels. Leur dimension de 6 cm de côté permet de diminuer le format des chambres à banc optique.

- Le photographe Alec Jackson lors d’une compétition de golf le 6 septembre 2008, transportant un double équipement argentique et numérique

- © Bernard Menettrier

Pour bien comprendre les phénomènes qui ont contribué à l’émergence du numérique, il faut aussi prendre en compte des aspects techniques peu visuels, mais qui sous-tendent tout son développement. Par exemple, la constante augmentation de la puissance de traitement des ordinateurs ainsi que des capacités de stockage ont été déterminantes. L’histoire des logiciels, très peu spectaculaire aussi d’un point de vue visuel, est un pan de cette histoire qui reste à étudier.

Les moins jeunes des visiteurs éprouveront un étonnement bizarre en découvrant cette courte tranche d’histoire. De revoir dans une perspective historique, des objets qu’ils ont côtoyés, sinon utilisés, procure un étrange sentiment : celui d’avoir participé un tout petit peu à l’histoire ;-) Les plus jeunes pourront mesurer que des objets qu’ils considèrent comme allant de soi ne sont guère plus âgés qu’eux.

L’exposition présente une vidéo faite d’interviews d’une dizaine de photographes de l’USPP (Union Suisse des Photographes Professionnels) au sujet de leur première photo numérique. Ces quelques témoignages sans prétention, sont toutefois très révélateurs de l’état d’esprit, fait de retenue et de réticence, qui a présidé à l’adoption du numérique par les pros. Les amateurs, qui certes n’avaient rien à perdre, n’ont pas fait tant d’histoires ;-) La plupart n’avaient d’ailleurs jamais pratiqué l’argentique auparavant. La vidéo est visible sur YouTube en 2 parties.

Son objet étant en plein développement, l’exposition s’ouvre à quelques développements actuels autour de l’imagerie numérique. C’est ainsi que des travaux de divers chercheurs sont présentés et animés par des démonstrations... interactives ! Particulièrement remarquables, sont les expériences du Laboratoire de communications audiovisuelles de la Faculté informatique et communications de l’EPFL (École Polytechnique Fédérale de Lausanne) qui portent sur des développements dans le domaine de la réalité augmentée ou sur la photographie dans l’infrarouge proche permettant la correction instantanée et automatique d’imperfections du visage. L’Imaging & Media Lab de l’université de Bâle présente, pour sa part, des travaux permettant de restituer les couleurs originales d’anciens tirages couleur qui, comme tout le monde a pu le constater, disparaissent irrémédiablement. (J’entends d’ici hurler les chercheurs en histoire visuelle ;-)

Je reviendrai peut-être ultérieurement sur cette partie de l’exposition, mais en attendant, je vous invite à découvrir par vous-mêmes les expériences évoquées ci-dessus et d’autres encore, directement au musée.

Signalons qu’à l’exception de la partie traitant des recherches actuelles, ce nouveau dispositif d’exposition est appelé à durer, car il est la première partie d’une refonte plus générale du musée. L’exposition dans sa forme actuelle est visible jusqu’au 31 décembre 2010.

Notes:

[1] D’une façon très très généralisée, on peut dire que les théories reposant sur l’indicialité bénéficient d’un nouvel éclairage depuis l’émergence du numérique, sans que ce soit là la raison principale de leur remise en question. Quelques liens pour approfondir cette question :

• Au doigt ou à l’oeil ? - Etudes photographiques - André Gunthert

• La part du visible ou la valeur indicielle de la photographie dans le savoir historique - L’Atelier du LHIVIC - Martine Robert

• La retouche numérique à l’index - Etudes photographiques - Tom Gunning

[2] Pour moi, cela a correspondu à l’essoufflement d’un « marché » de l’illustration et m’a permis de prolonger, à travers la photo, mes activités de faiseur d’images. Cela peut expliquer ma liberté vis-à-vis des tabous liés la retouche ;-)

[3] J’en ai possédé un et j’ose à peine avouer que je l’ai jeté à peu près en même temps que mes câbles SCSI et mon lecteur SyQuest !

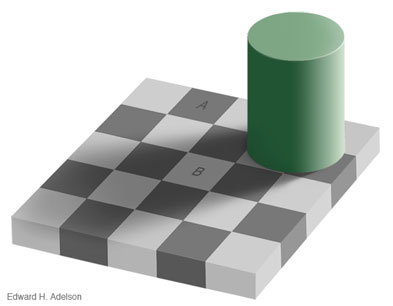

Je reprends une illusion d’optique, bien connue, due à Edward H. Adelson, car elle met en lumière certains effets du contraste local. Cette illusion illustre parfaitement le fait que notre système visuel est bien plus sensible à la valeur relative de la luminosité qu’à sa valeur absolue, comme je l’expliquais dans mon précédent article sur le contraste local. Autrement dit - et c’est E.H. Adelson qui le relève - notre oeil serait un bien mauvais posemètre ! En effet, pour bien comprendre la nature des objets qui nous entourent, notre système visuel doit pouvoir interpréter subtilement les différences de luminosité, même si cela doit se faire au détriment d’une mesure correcte de la luminosité absolue.

Dans l’image ci-dessous, les 2 carrés A et B nous apparaissent chacun d’un gris bien différencié de l’autre...

En réalité, ils sont exactement du même gris !!

Tout le monde est surpris et reste sceptique à cet énoncé. Passez la souris sur l’image pour voir l’évidence : les 2 bandes verticales ajoutées sont du même gris que les 2 carrés et prouvent qu’ils sont bien de la même couleur.

Mais comment cela se fait-ce ? E.H. Adelson nous fournit des explications (que j’adapte librement) :

Pour déterminer la nature des objets observés, notre système visuel ne peut se contenter de mesurer leur luminance. Dans notre exemple, une ombre portée modifie la valeur de gris réfléchie par certains carrés du damier. Le système visuel utilise plusieurs stratégies pour compenser cet effet :

• Une première approche est basée sur le contraste local (le revoilà). Chaque carré est comparé à ses voisins immédiats. Un carré entouré d’autres plus foncés est jugé « blanc », alors qu’un autre, entouré de carrés clairs est jugé « noir ». Et cela qu’il y ait une ombre portée ou pas.

• Le système visuel tend à ignorer les changements graduels de luminosité (celle de l’ombre portée), lui préférant les limites nettes (celle des carrés). Les ombres ayant souvent des bords flous, leur perception est de ce fait diminuée au profit du dessin précis des carrés. Ici, l’effet d’ombre portée est d’autant mieux perçu que l’objet qui le produit est visible dans l’image.

• Le damier est reconnu comme un ensemble géométrique où 2 tons différents alternent régulièrement. La couleur de chaque carré est prévisible et ne saurait donc « mentir ».

Cela doit nous rendre attentifs à la construction des images et à leur fonctionnement qui peut parfois nous échapper. Je ne parle évidemment pas, ici, de la portée conceptuelle ou métaphorique des images, mais de la perception primaire des « objets » qu’elles sont sensées représenter. Une représentation dénuée d’ambiguïtés dans la forme me semble un prérequis nécessaire pour qu’une image puisse délivrer son fond. (À moins que l’ambiguïté ne soit expressément recherchée ! Mais cela ne me semble pas toujours être le cas ;-)

Edward H. Adelson est Professor of Vision Science - Dept. of Brain and Cognitive Sciences - Massachusetts Institute of Technology (MIT). Il présente ici son illusion d’optique. Sur ce document (Lightness Perception and Lightness Illusions) il nous expose en détail et à l’aide de nombreuses illusions d’optique sa théorie de la perception de la luminance. Si vous avez aimé cela, vous trouverez d’autres illusions d’optique ici. Et si décidément l’été se fait pluvieux, en voici d’autres encore.

PS 1 : Les sceptiques qui n’en croient toujours pas leurs yeux - il en reste, je le sais ! - sont en général les mêmes qui ne croient pas que la lune a le même diamètre à son lever qu’au plus haut dans le ciel... (Tentative de) persuasion ici.

PS 2 : Dans ce billet, je vous ai parlé de 2 carrés et vous avez très bien compris que je désignais en réalité des parallélogrammes qu’on peut voir sur l’image... Autre exemple de l’interprétation que nous faisons de ce que nous voyons ;-)

La technique façonne le média. En photo argentique, de nombreux artefacts provoqués par des caractéristiques ou des limitations techniques sont devenus des archétypes esthétiques (grain, flou, déformations optiques, etc). Avec les techniques numériques - en grande rupture par rapport aux argentiques - nos canons esthétiques seront immanquablement modifiés, poussés par des particularités techniques jamais encore appliquées. Parmi celles qui ont déjà un impact, il faut relever les techniques qui sont liées au contraste local.

Le contraste local est une notion utilisée depuis longtemps par les chercheurs en perception visuelle. Ses données sont analysées et prises en compte en tant que paramètres dans l’élaboration de différentes théories scientifiques ayant trait à la vision. [1]

Ici, cette notion nous permettra surtout de mieux comprendre certaines différences entre nos perceptions visuelles et ce que peut recueillir un capteur photographique, que celui-ci soit argentique ou numérique. Avant les traitements numériques, elle n’avait jamais trouvé de réelle application pour l’élaboration des images. Chez les photographes, ce n’est que fortuitement que son principe a été appelé en renfort pour expliciter le résultat de quelques bidouillages ! Mais, commençons par le début...

Tout le monde sait ce qu’est un contraste : dans le monde visuel, c’est le rapport entre des zones claires et des zones sombres. La juxtaposition de noir et de blanc provoque, par exemple un fort contraste, alors que celle de deux gris moyens offre plutôt un faible contraste. Notre oeil distingue bien évidemment ces contrastes, mais il a une manière particulière de les appréhender. Faut-il redire qu’à la différence d’un appareil photo, notre oeil (et le cerveau qui lui est lié) opère des interprétations de ce qu’il voit ? L’appareil photo, lui, capture des images, d’une manière qu’on peut qualifier de « mécaniquement objective », ne seraient ses défauts techniques inhérents, par ailleurs connus et prévisibles.

L’étendue des tons - du plus sombre au plus clair - visibles dans la nature est très large. Notre oeil peut capter cette gamme dans son intégralité, mais dans certaines conditions seulement : il ne peut la couvrir de façon détaillée en un seul regard. Par contre, en fixant des zones différentes, la pupille s’adapte à la luminosité de ces zones et laisse passer des informations spécifiques. Par exemple, éblouis par un ciel clair nous ne percevons pas les détails dans les ombres. Mais si nous dirigeons notre regard vers ces ombres nous pouvons en distinguer certains. Pour bien le constater, exagérons cet effet en tenant devant nous un carton noir percé d’un trou (voir simulation ci-dessous en passant la souris sur l’image). Le carton, en occultant la forte luminosité du ciel, permet à l’oeil (à l’iris) de s’adapter à la luminosité plus faible des ombres.

Le phénomène se produit également dans des conditions normales (sans utiliser ce carton noir), mais dans des proportions moindres, car la vision périphérique prend en compte la luminosité de tout notre champ de vision. Notre oeil, en déplaçant son regard, non content d’adapter constamment sa focale, s’adapte aussi à la luminosité de la zone qu’il fixe, nous permettant ainsi de discerner des détails (voir simulation dans l’image ci-dessous en passant la souris sur l’image). L’effet n’est évidemment pas ressenti comme sur cet exemple, car notre cerveau - merveille de la nature - retraite ces informations morcelées et nous fait croire à la continuité de ce que nous voyons. Mais si nous avions un cerveau moins perfectionné, nous pourrions bien le ressentir comme cela ;-)

La grande gamme dynamique disponible est donc constituée d’une infinité de tons intermédiaires que nous ne discernons pas immédiatement. Quand notre regard se déplace, notre oeil ne fait rien d’autre que de tenter d’isoler une zone du reste du champ de vision. En faisant cela, il sélectionne une partie seulement de la gamme des tons disponibles. Mais dans cette gamme réduite, qui occupe ainsi tout son champ d’analyse, et cela grâce à de nouvelles conditions de luminosité, des tons intermédiaires se révèlent. De nouvelles conditions de contrastes, différentes de celles qui affectent l’ensemble du champ de vision, sont ressenties par notre système de vision. On les appelle des « contrastes locaux », par opposition au contraste « global », que nous connaissons tous. L’ensemble de ces mesures ponctuelles nous permet ainsi d’appréhender, au fur et à mesure, toute l’étendue et tous les détails de la gamme dynamique.

Le graphique ci-dessus montre à sa manière le phénomène d’augmentation du nombre de tons intermédiaires - Attention : ce dessin n’a rien de scientifique, il tente juste de traduire un « ressenti ».

• 1 : gamme de 26 niveaux de gris (remarquez au passage combien votre écran a déjà du mal à les afficher tous !).

• 2 : augmentation du nombre de tons intermédiaires par rapport à une certaine partie de la gamme dynamique (dans les tons foncés et dans les tons clairs). On remarque que, dans la direction des tons moyens (vers le milieu de la gamme), il y a une « création exagérée » de nouvelles nuances.

En photo, les choses se présentent d’une manière fort différente. Un capteur numérique n’est pas capable d’enregistrer toute l’étendue de la gamme dynamique [2] !. Pire, nos dispositifs de visionnage sont très limités et ne permettent souvent pas de voir l’intégralité de la gamme enregistrée par le capteur. Un bon écran d’ordinateur n’est capable, en théorie, d’afficher que 256 niveaux de gris. (Les blancs de la nature sont infiniment plus blancs que ceux de vos écrans ! - même remarque pour les noirs.) Et cela se gâte sérieusement si nous voulons imprimer une image : pour l’offset, environ 90 niveaux de gris. Comme nous voulons tout de même voir les extrêmes (les noirs et les blancs) la gamme affichée entre ces deux pôles manque de nuances : beaucoup de valeurs intermédiaires sont tout bonnement absentes. Sans autre intervention, les images présentent alors souvent des noirs « bouchés » et des blancs « brûlés ». On peut certes corriger sommairement ces défauts à la prise de vue en privilégiant, par exemple, les tons foncés, mais c’est alors les tons clairs qui en pâtissent et vice versa. Dans nos logiciels, on peut aussi, dans certaines limites, reproduire les vieilles recettes du labo argentique en jouant de la « maquillette »... C’est à dire, en sur-exposant certaines zones et en sous-exposant d’autres. Mais ces effets sont limités.

La grande différence entre une reproduction photographique et la vision directe de la même scène est que, sur la photo, toutes les informations sont figées (vous vous en doutiez, mais à ce point de l’exercice il est important de le souligner !). Notre oeil a donc beau chercher, même en s’y arrêtant avec insistance, il ne trouvera rien de plus dans les différentes zones de l’image que ce que montre l’écran ou l’imprimé.

Nous savons que le capteur a enregistré plus de niveaux de gris que les 256 que nous pouvons afficher (au mieux). De nombreuses techniques numériques, de plus en plus sophistiquées, ont été développées pour faire « remonter » ces informations et les rendre visibles tout en tenant compte des piètres performances de nos dispositifs de visionnage. L’une des premières, très simple et très efficace, a été « découverte » -comme le relate Michael H. Reichmann (en 2003) sur son site Luminous Landscape - par Thomas Knoll (qui n’est autre que l’inventeur de Photoshop). Le plus étonnant est que la technique est basée sur l’utilisation détournée d’un filtre « classique » du logiciel !

Dans mon billet sur la netteté des images je montrais comment on leurrait notre regard en augmentant le contraste des pixels sur les contours des objets. Cela se fait (sur Photoshop) à l’aide du filtre Accentuation [3]. Ce filtre détecte les contours et leur ajoute du contraste sur une zone (un halo) qui peut s’étendre, de chaque côté du contour, de 1 à ... disons 3 pixels. (On peut évidemment y régler d’autres paramètres que je n’aborderai pas ici, c’est déjà assez pénible pour les technophobes ;-). Certains bidouilleurs (au rang desquels je n’oserais ranger Thomas Knoll - mais pour moi le terme n’est pas infamant) ont remarqué que ce petit halo, utile pour améliorer la netteté, pouvait être élargi jusqu’à des valeurs de 50 ou 100 pixels et produire des effets spectaculaires. [4] Quand l’augmentation du contraste est appliquée sur une si large étendue, le logiciel « remonte » des informations sur les tons intermédiaires qui n’étaient pas affichés avant. Ci-dessous : l’image entière à laquelle a été appliqué ce procédé (passer la souris...)

De fait, une photo traitée de cette manière, présente en continu et en permanence, tous les détails que l’oeil devrait « fabriquer » s’il était en condition de vision directe de la même scène. Ce n’est donc qu’une tentative d’« imitation de la réalité » de plus ! Une image, quoi ;-) L’effet obtenu, si la correction est appliquée modérément, nous fait ressentir l’image comme nettoyée, désembuée. Un peu comme nous pouvons le voir dans un ciel de traine, après que l’atmosphère ait été nettoyée par d’abondantes pluies. Notre cerveau, cherchant dans sa panoplie des possibles, trouve là probablement, un élément d’explication...

Précisons qu’il n’y a pas plus de niveaux de gris sur une image de ce type. On « se débrouille » avec ceux que l’on a, mais on les redispose d’une manière « plus profitable ». Et ça marche, car notre oeil est plus sensible à la valeur relative de la luminosité qu’à sa valeur absolue. Remarquons que sur les images, le contraste « local » n’est pas plus une vision idéalisée que le contraste « global ». Aucune de ces visions des contrastes ne correspond vraiment au monde tel qu’on peut le voir en direct. Tout au plus, peut-on affirmer que le contraste « local » tend à nous rapprocher un peu plus d’une bonne description de la « réalité » (et encore !).

Les images ci-dessous (oui, avec la souris...) permettent de comparer les différences entre le contraste « global » et le contraste « local »...

Comparaison original > contraste global

Comparaison original > contraste local

Comparaison contraste global > contraste local

Il est clair que pour obtenir une bonne image il conviendrait de jouer des 2 effets, mais ce n’est pas le but de cet exercice ;-)

Ces résultats ont (probablement) motivé la recherche d’autres possibilités logicielles permettant d’exploiter une plus grande dynamique des tons. Plusieurs nouvelles fonctionnalités allant dans ce sens ont ainsi vu le jour dans nos programmes d’imagerie en proposant des réglages à la fois plus ciblés, plus intuitifs et plus puissants. [5]

Sur cette image (oui la souris...) on observe bien ce fonctionnement de « révélation » de nouveaux contrastes locaux. Remarquez que les bords de l’ombre de l’arbre (p. ex. sur le chemin) ne changent pratiquement pas. Tout se passe à l’intérieur de la partie ombrée.

Voilà pour les prodiges de la technique. Si je vous impose ces laborieuses explications, ce n’est pas juste pour nous émerveiller des beautés de la nature et du génie humain ! Mais c’est que ces nouvelles possibilités vont avoir (et ont déjà) des influences sur l’apparence des images. À cet instant, il n’est pas possible de préjuger de l’étendue des modifications que vont engendrer ces technologies. Mais il me parait utile de pouvoir déjà noter le phénomène, l’identifier, le reconnaitre. Il faut souligner ici, que les modifications qu’opèrent ces technologies sur les images sont véritablement innovantes, en ce sens qu’elles n’avaient jamais pu être réalisées auparavant en argentique.

Nous avons tous, peu ou prou, une culture imagière basée sur la somme des images que nous avons vues. Par exemple, nous nous sommes tous habitués à ces clairs-obscurs - chers aux peintres de la renaissance - que la photo s’est en quelque sorte réappropriés, aidée en cela par des contraintes techniques intrinsèques. Ces noirs profonds dessinant de belles compositions graphiques et masquant les détails à notre regard - les transformant en autant de mystères - sont devenus des éléments constitutifs de nos canons esthétiques. Va-t-on, parce que la technique le permet, remplir ces ombres de détails ? Allons-nous compter toutes les feuilles des arbres ? Les ciels sereins de nos photos, vont-ils systématiquement présenter des visions d’orages apocalyptiques ? Bref, comment notre culture visuelle va-t-elle intégrer ces changements ?

Dans une vision optimiste, on peut penser que pour les domaines de l’expression personnelle (de l’art !) ces nouvelles perspectives apportent un plus riche potentiel de créativité. Mais en parallèle, il faut s’attendre aussi à tout autant d’excès mal venus (selon Audiard, il y en a « qui osent tout » ;-) Cela reste évidemment très subjectif, car, sous l’empire des archétypes esthétiques d’aujourd’hui, nous ne pouvons préjuger de ceux de demain.

Dans une perspective utilitariste, il faut reconnaitre qu’appliquées avec mesure, ces techniques peuvent apporter leur lot d’enrichissements visuels en révélant sur une image bien plus de détails qu’on pouvait en espérer avant. Les documentaristes apprécieront. Mais gare aux illusions : trop d’informations noient l’information ! La multiplication d’éléments anecdotiques peut agir comme un élément perturbateur de l’expressivité des images. La profusion de détails va-t-elle devenir un artefact constitutif de l’esthétique de nos photos ? Je vous laisse imaginer ce que ces techniques, appliquées sans discernement à des visages, peuvent y révéler de détails qu’on cherche d’ordinaire à cacher...

Dans l’image ci-dessous (la souris... pfhh), on peut se demander ce qu’apporte le débouchage des noirs... Les botanistes y verront peut-être des éléments dignes d’intérêt, mais je ne suis pas sûr que tout le monde y trouve son compte...

Ma vraie crainte est la généralisation de ces technologies dans des processus automatiques ignorés et ingérables par les utilisateurs (dans des appareils compacts, imprimantes, labos de tirages papier, etc). Après avoir vu débarquer des fonctions telles que la reconnaissance des visages ou la détection des sourires, il ne faut plus s’étonner de rien : la standardisation est en marche ! En vieux con pessimiste - ayant connu la vie ante-digitale - je constate que sur le fond, la standardisation (celle qui nivelle toujours par le bas !) intervient quasi automatiquement dans les réalisations résultant des activités « d’avant » dont s’empare l’informatique. C’est un de ses effets collatéraux majeurs qui est souvent masqué par la brillance des technologies et leur démocratisation. Mais peut-être que cette standardisation permettra justement à des auteurs intelligents, cultivés, habiles et créatifs d’en émerger... Que ces derniers utilisent alors, ou non, ces nouvelles technologies est une question secondaire.

Notes:

[1] Quelques éléments d’intérêt :

• Contrast and visibility / Rapport CIE 95, 1992 / Roland Brémond :

« La première étape de traitement de l’information visuelle a lieu avant les récepteurs photosensibles de la rétine : la lumière incidente traverse une couche de cellules, de taille importante par rapport à l’espacement entre les cônes de la rétine, et qui participent à l’extraction de détails fins. Ce processus reste mystérieux. »

Nous voilà bien avancés ;-)

• Quelques traitements bas niveau basés sur une analyse du contraste local / A. Le Negrate, A. Beghadi, K. Boussaïd-Belkacem :

« Ce traitement a pour effet de déplacer le niveau de gris du pixel d’une quantité proportionnelle à l’écart par rapport au niveau de gris moyen des contours. Notons qu’un pixel appartenant au contour n’est pas modifié. Il s’agit donc d’une transformation bidirectionnelle. Ceci a pour conséquence immédiate de renforcer le contraste tout en préservant la position des pixels des contours. »

On voit ici que bien avant que la pratique ne se répande chez les photographes, des chercheurs s’étaient penchés (1989) sur ce type de traitement...

• Wikibooks : Photographie / 14 - Netteté des images photographiques / L’œil et la perception de la netteté :

« La perception d’un fin détail dépend en fait au moins autant, sinon plus, du contraste local et de la netteté de ses bords que de ses dimensions. Placé à 1 m d’une surface blanche bien éclairée, l’œil « normal » y distinguera sûrement un point noir de 0,25 mm de diamètre mais pas une chiure de mouche jaune pâle de 1 mm de diamètre, pourtant beaucoup plus grande. »

[2] Pour un écran standard, la gamme dynamique a un rapport de 256:1 (en 8 bits, donc en noir/blanc). En couleurs, chaque canal étant codé sur 8 bits nous obtenons 256 x 256 x 256 = 16 millions de couleurs. Mais cela ne change rien au problème de fond : la luminosité n’a toujours que 256 niveaux. (Nous pouvons le constater si nous passons en mode Lab.) Certains APN, en format Raw, codent les informations jusqu’à 14 bits et peuvent théoriquement capter une gamme dynamique allant jusqu’à 16364:1. Mais la gamme dynamique des scènes réelles est encore beaucoup plus étendue : un paysage ensoleillé peut offrir un rapport de 100’000:1, voire plus

[3] Mal nommé en anglais : Unsharp Filter

[4] Il semblerait donc qu’une fois de plus, la sérendipité - qui aurait déjà valu à Daguerre une découverte importante dans la mise au point du daguerréotype - soit à l’origine de nouvelles percées techniques dans le monde de la photographie...

[5] La commande « Tons foncés/Tons clairs » de Photoshop (utilisée dans la plupart des exemples de cette page) va dans ce sens et exige déjà un certain doigté pour ne pas tomber dans l’excès, comme je l’ai fait pour bien le montrer. DxO Optics Pro, de son côté, propose des traitements pouvant avoir des effets pour le moins spectaculaires, avec le défaut - à mon avis - qu’ils font partie des réglages standards que peu de gens vont désactiver, ou du moins tempérer. D’autres techniques, par exemple la HDR (High Dynamic Range), sur laquelle nous reviendrons, peuvent produire des résultats proprement hallucinants, capables de bousculer gravement nos habitudes visuelles.

NB : Sur tous les exemples de ce billet, les procédés ont été appliqués sur l’image entière. Il est bien évident que, pour obtenir des résultats optimaux, on peut les appliquer (ou pas, ou de manière différenciée) sur des zones choisies. Certains logiciels (Nikon Capture) sont d’ailleurs axés sur cette particularité.