Ce blog n’existe plus. Mais comme il est toujours là, je peux encore le mobiliser quand ça me chante. Par exemple, lorsqu’une image me donne le vertige.

« Pale Blue Dot » est une célèbre image de la Terre prise en 1990 par la sonde Voyager 1. Elle a été récemment republiée, après que la NASA lui ait appliqué de nouveaux traitements d’image plus performants que ceux dont on disposait à l’époque. On y voit un petit point bleu pâle représentant la terre vue d’une distance de 6,4 milliards de kilomètres. À ce moment, la sonde a quitté le système solaire et on s’apprête à éteindre ses caméras pour conserver un peu d’énergie. Ce regard en arrière n’était pas prévu dans la mission et c’est sur l’insistance de Carl Sagan qu’une série d’images du système solaire a pu être réalisée.

Si, à la place de votre smartbidule, vous disposez d’un écran d’ordinateur, cliquez sur l’image pour l’agrandir. À ce format on saisit mieux la dimension dérisoire de ce pixel bleu clair perdu au milieu de l’espace.

En 1994 Carl Sagan publiait un livre appelé … « Pale Blue Dot : A Vision of the Human Future in Space ». Voici comment il décrivait cette image dans un texte qui, aujourd’hui, s’inscrit parfaitement dans la dimension vertigineuse des défis climatiques :

« Regardez encore ce petit point. C’est ici. C’est notre foyer. C’est nous. Sur lui se trouvent tous ceux que vous aimez, tous ceux que vous connaissez, tous ceux dont vous avez entendu parler, tous les êtres humains qui aient jamais vécu. Toute la somme de nos joies et de nos souffrances, des milliers de religions aux convictions assurées, d’idéologies et de doctrines économiques, tous les chasseurs et cueilleurs, tous les héros et tous les lâches, tous les créateurs et destructeurs de civilisations, tous les rois et tous les paysans, tous les jeunes couples d’amoureux, tous les pères et mères, tous les enfants plein d’espoir, les inventeurs et les explorateurs, tous les professeurs de morale, tous les politiciens corrompus, toutes les “superstars”, tous les “guides suprêmes”, tous les saints et pécheurs de l’histoire de notre espèce ont vécu ici, sur ce grain de poussière suspendu dans un rayon de soleil.

La Terre est une toute petite scène dans une vaste arène cosmique. Songez aux fleuves de sang déversés par tous ces généraux et ces empereurs afin que nimbés de triomphe et de gloire, ils puissent devenir les maîtres temporaires d’une fraction d’un point. Songez aux cruautés sans fin imposées par les habitants d’un recoin de ce pixel sur d’indistincts habitants d’un autre recoin. Comme ils peinent à s’entendre, comme ils sont prompts à s’entretuer, comme leurs haines sont ferventes. Nos postures, notre propre importance imaginée, l’illusion que nous avons quelque position privilégiée dans l’univers, sont mis en question par ce point de lumière pâle. Notre planète est une infime tache solitaire enveloppée par la grande nuit cosmique. Dans notre obscurité — dans toute cette immensité — il n’y a aucun signe qu’une aide viendra d’ailleurs nous sauver de nous-mêmes. La Terre est jusqu’à présent le seul monde connu à abriter la vie. Il n’y a nulle part ailleurs, au moins dans un futur proche, vers où notre espèce pourrait migrer. Visiter, oui. S’installer, pas encore. Que vous le vouliez ou non, pour le moment c’est sur Terre que nous prenons position.

On a dit que l’astronomie incite à l’humilité et fortifie le caractère. Il n’y a peut-être pas de meilleure démonstration de la folie des idées humaines que cette lointaine image de notre monde minuscule. Pour moi, cela souligne notre responsabilité de cohabiter plus fraternellement les uns avec les autres, et de préserver et chérir le point bleu pâle, la seule maison que nous ayons jamais connue. »

Détails sur ce texte en français.

Et ici en VO anglaise.

L’image est présentée sur le site de la Nasa, ici.

Rubrique: A propos d’images

Ce blog n’est plus alimenté, mais pour l’instant il reste là, dans son jus.

Beaucoup d’articles ne sont plus en prise avec l’actualité, alors que certains sont devenus carrément obsolètes. Et je ne parle même pas de ceux qui ne sont pas très bons ou insignifiants. Quelques textes - peut-être un peu mieux documentés et plus réfléchis que d’autres - sont toujours consultés par des internautes curieux. Il y en a qui sont référencés par des écoles. Et je découvre parfois que la presse en ligne, voire même une encyclopédie très célèbre, référencent l’un ou l’autre de mes textes.

La plupart des liens sont cassés. Cela enlève du crédit aux thèses que je pouvais étayer avec ces citations. Cela montre que l’éternité sur le net ne dure pas très longtemps. C’est peut-être pour tenter de démentir cette orientation funeste que je conserve encore ce vieux blog (commencé, à une adresse différente, le 1er mai 2006 puis sérieusement ralenti depuis 2012).

La période active du blog Mots d’images s’est déroulée alors que la photographie numérique passait du stade émergent à celui de l’ébullition. Durant ces années, le numérique conquérait tous les marchés, celui du matériel, de la publication et de l’éditorialisation. Les professions photographiques en étaient profondément chamboulées, alors que le public vivait sa première lune de miel avec la « photo facile » (la 2e, bien plus importante, arrivera avec les smartphones et les réseaux sociaux).

La digitalisation consécutive des images a permis des interventions sur les pixels (la retouche, quoi !). Ces « intrusions », auparavant difficiles à réaliser, ont suscité des discussions passionnées remettant chaque fois en question le statut des images. Ces débats m’ont captivé et j’avais même entrepris de les collectionner dans Le petit observatoire de la retouche. Maintenant, ces polémiques me semblent bien loin (voir ici, le point sur la situation actuelle). Mais à l’occasion de quelque « affaire » liée au statut de vérité des images, on se rend bien compte que des croyances simplistes sont tenaces.

Aujourd’hui, tout le monde fait des photos à tort et à travers sans trop y réfléchir. Et c’est sûrement très bien. Mais qu’y a-t-il de commun entre un selfie avec ma grand-mère et un portrait d’Harcourt ? Entre le plat de nouilles de la cantine et une nature morte ? Entre une photo de famille idéale de Fotolia et la vôtre prise lors du dernier anniversaire de la petite ? Entre l’image de pub d’une Tesla et celle des faits divers avec une Toyota au fond d’un ravin ? Entre la photo de mon chat et la photo d’un lion pour la pub du Nikon ? On désigne sous le vocable « photo » tous les types d’images réalisées automatiquement. Ce qui n’est au fond qu’un procédé technique sert à nommer une infinie variété d’images produites dans des conditions et des intentions qui n’ont pas grand-chose en commun.

Ne pouvant changer ou enrichir le vocabulaire, il faut toujours et encore se référer au contexte pour savoir à quelle image on a affaire. Cette subjectivité qui se niche dans les images nous laisse une avance incoercible sur les applications de reconnaissance visuelle. Les algorithmes ne sauront jamais nous dire, à l’instar de Magritte, que « Ceci n’est pas une pipe ».

Je voulais juste faire un petit alinéa pour expliquer aux nouveaux venus les conditions de ce blog et me voilà reparti…

Rubrique: A propos d’images

Vous n’avez jamais rêvé de domestiquer les nuages ?

Moi oui, je l’ai fait et vous pouvez le voir dans mes galeries d’images : photographiste.ch

Les photomontages sont disponibles en tirages d’art sur papier, numérotés et signés.

Les photomontages sont disponibles en tirages d’art sur papier, numérotés et signés.

- © Béat Brüsch, 1998 - CC BY-NC-ND

À lire :

• La défaite Charlie, André Gunthert

• Charlie à tout prix, Frédéric Lordon

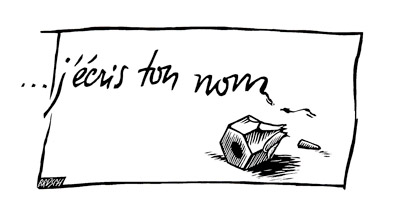

• Ah, et puis aussi Paul Eluard

Rubrique: A propos d’images

Rubrique: A propos d’images